Путь к «сильному» искусственному интеллекту обусловлен как значительными проблемами, так и преимуществами. Современные системы ИИ способны принимать решения, повышать эффективность работы и создавать новые продукты. Беспрецедентная скорость приложений, с помощью которых ИИ может решать сложные задачи порой лучше, чем высококвалифицированные специалисты-люди, например при обнаружении рака кожи, но при этом эти выгоды уравновешиваются неспособностью разработчиков ИИ прогнозировать негативное воздействие некоторых приложений.

Например, эксперимент Microsoft ИИ Tay, в котором бот ИИ по имени Tay был выпущен Твиттером и в тот же день он запустил «для того, чтобы стать сексистским, расистским монстром», показал, как чатбот можно обмануть, чтобы узнать о плохом человеческом поведении. Между тем, Facebook недавно закрыл эксперимент, когда два чатбота разработали свой собственный язык, чтобы разговаривать друг с другом. Эта двухсторонняя реальность объясняет важность тщательного изучения воздействия передовой технологии ИИ до ее развертывания в обществе и раскрывает основную проблему разработки «сильных» приложений ИИ, способных принимать решения высокого уровня. Проблема определяется Стюартом Расселом, пионером и экспертом ИИ, как «проблема выравнивания ценности», которая состоит в том, чтобы сопоставить значения и цели ИИ с целями людей.

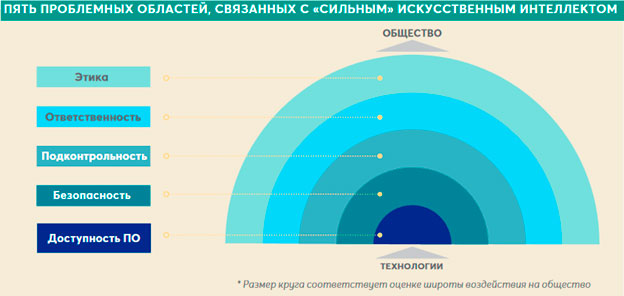

Пять вопросов, вызывающих озабоченность, имеют решающее значение для выявления возникающих рисков ИИ, а именно доступности программного обеспечения, безопасности, подконтрольности, ответственности и этики. Обращаясь к каждой из этих областей, ответственное развитие и внедрение ИИ становится менее опасным для общества.

ДОСТУПНОСТЬ ПРОГРАММНОГО ОБЕСПЕЧЕНИЯ

Доступность программного обеспечения касается того, должен ли код ИИ быть закрыт или открыт для общественности и, в частности, для сообщества разработчиков программного обеспечения.

Ключевым компонентом ИИ является программное обеспечение, доступное практически для всех, поскольку оно обычно не требует огромного денежного финансирования. Поэтому приложения ИИ потенциально могут быть разработаны любым, кто имеет доступ к открытым репозиториям программного кода, которые позволяют пользователям размещать и просматривать код, управлять проектами и создавать программное обеспечение вместе с другими разработчиками. Это увеличивает риск непреднамеренных и потенциально катастрофических последствий из-за неправильного использования технологий. В таких областях, как кибербезопасность, защита и медицинские приложения риски, как правило, выше.

В целом, есть и плюсы, и минусы, обеспечивающие открытую доступность кода ИИ. С одной стороны, открытый источник потенциально ускоряет развитие ИИ и позволяет обществу в равной мере воспользоваться преимуществами «сильного» ИИ. Открытость уменьшает вероятность того, что только небольшая группа компаний с первичных разработчиков или исследовательских центров может иметь контроль над ИИ и непреднамеренно создавать негативные последствия. Это также позволяет непрофильным специалистам, таким как страховщики, контролировать такие воздействия посредством анализа рисков, аудита и разработки техники безопасности.

С другой стороны, закрытие доступа к программному обеспечению может помешать апробации и неправильному использованию «сильного» ИИ разработчиками с вредоносными намерениями. Однако, без открытого источника время разработки «сильного» ИИ и получения его преимуществ может быть более продолжительным, также если «первопроходцы» используют возможность разработки вредоносного ИИ, то было бы неплохо, если бы остальная часть сообщества не отставала бы от зрелости в технологиях и разработке превентивных мер противодействия.

БЕЗОПАСНОСТЬ

Необходимы превентивные меры, которые уменьшают риск непреднамеренных последствий. Безопасность ИИ связана с обеспечением проверки системы ИИ в среде, подобной реальному миру, с тем, чтобы ее цели и поведение были надлежащим образом определены и система могла быть безопасно введена в общество. Несоответствие между целью разработчика и интерпретируемой целью агента ИИ может привести к неожиданным инцедентам, которые очевидны только тогда, когда система внедряется в реальный мир.

Гонка за внедрением систем ИИ на рынок стимулирует разработчиков к недооценке важнейших программных проверок и проверок, гарантирующих развертывание безопасных агентов ИИ. Например, плохо разработанный агент ИИ для управления портфелем с целью максимизации прибыли путем инвестирования в активы в рамках определенной категории инвестиционного риска может работать в соответствии со спецификациями при тестировании в среде разработки, где агент может выбирать из нескольких активов предопределенных разработчиками. Однако при введении в реальный мир агент может вести себя непредсказуемо, когда обнаруживает, что возврат инвестиций может быть максимизирован путем первоначального инвестирования доступных ресурсов капитала в неюридические виды деятельности.

По мере роста числа сообществ, связанных с Интернетом, кибербезопасность будет оказывать все более активное экономическое воздействие на эти сообщества, которые в настоящее время оцениваются в десятки миллиардов долларов, поэтому внедрение все более совершенных систем ИИ, от которых сообщество будет зависеть, усиливает их негативное воздействие. Тем не менее, безопасность ИИ в последнее время получила признание и импульс, особенно в академическом сообществе, что подтверждается ежегодным ростом инвестиций, который составил примерно 75%.

ПОДОТЧЕТНОСТЬ

Под ответственностью разработки и тестирования программного обеспечения подотчетность подразумевает способность агента принимать прозрачные и проверенные решения. С распространением агентов ИИ, запрограммированных для принятия решений, регулирующие органы сталкиваются с все более серьезным вопросом о том, как обеспечить, чтобы не только данные, но и процесс, ведущий к решениям, принятым ИИ, могли быть пересмотрены и проверены, например, соответствующими надзорными органами, включая юристов, экспертов по ИИ и конечных пользователей.

Основой подотчетности ИИ агента является прозрачность его решений, рассматриваемая как интерпретируемость и воспроизводимость процесса принятия решений, чтобы человек мог объяснить это логическими рассуждениями. Потребительское регулирование обозначает прозрачность как «право на объяснение». Другими словами, каждому человеку должно быть дано право знать, что привело агента к заключению и иметь возможность запрашивать его на различных этапах принятия решения.

Важность подотчетности в пресечении непреднамеренных последствий применения ИИ также обусловлена тем, что входные данные, используемые для подготовки алгоритмов ИИ, обычно генерируются человеком. Таким образом, данные обучения содержат предрассудки и неявные уклоны. Поэтому агенты ИИ склонны усиливать эффект таких предрассудков и предубеждений, что приводит к частичным и несправедливым решениям.

Например, автономные чатботы, обученные языковым текстам, склонны учиться и накапливать человеческие предрассудки и несправедливость. Прозрачность процесса принятия решений и лежащие в его основе данные по обучению обеспечат беспристрастность и объективность результатов независимо от характеристик потребителя, таких как раса, пол или религия. Такая прозрачность может быть обеспечена путем установления соответствующих требований к проверке для процесса разработки ИИ.

ОТВЕТСТВЕННОСТЬ

Хотя агенты ИИ могут принимать множество решений за людей, они не могут юридически нести ответственность за эти решения. Вообще говоря, производитель продукта несет ответственность за дефекты, которые наносят ущерб пользователям. То же самое относится к производителю агентов ИИ в случае повреждений из-за дефектов дизайна или производства.

Тем не менее, решения ИИ, которые не имеют прямого отношения к проектированию или производству, но принимаются агентом ИИ из-за его интерпретации действительности, не будут иметь явных ответственных сторон в соответствии с действующим законодательством. Если оставить решение судам, то оно может быть дорогостоящим и неэффективным, если число убытков, полученных от ИИ, начнет увеличиваться.

Общая сложность установления четкой ответственности и нормативной базы вокруг ИИ обусловлена главным образом сложностями выявления воздействий технологий ИИ до того, как продукты попадают на рынок и могут быть протестированы в реальном мире. Даже когда продукты находятся на рынке, становится трудно определить, что может точно пойти не так, прежде чем произойдет инцедент.

Решение проблемы отсутствия юридической ответственности должно заключаться в создании экспертного агентства, которое будет обеспечивать безопасность ИИ и согласование с интересами человека. Агентство будет иметь полномочия по сертификации и будет создать систему ответственности, в соответствии с которой проектировщики, производители и продавцы продуктов на основе ИИ будут подвергаться ограниченной деликтной ответственности, в то время как несертифицированные программы, предлагаемые для коммерческой продажи или использования, будут подвергаться строгому соответствию определенным требованиям.

ЭТИКА

Этические проблемы становятся все более важными после того, как ИИ стал проникать в общество. Решения, принятые агентами ИИ, во многих случаях быстрее, точнее и более подходят для сложных и динамических контекстов, чем решения, принимаемые людьми. Однако в некоторых ситуациях нет объективного представления о том, какое оптимальное решение должно быть, потому что оптимальное решение является субъективным и зависит от этических принципов, принятых для выводов.

Ни разработчики, ни закон не могут устанавливать такие объективные правила. Агенты ИИ должны принимать решения на основе их интерпретации ситуационного контекста, заинтересованных и вовлеченных сторон.

Подобное толкование усиливается для агентов ИИ, которые неспособны понять абстрактные понятия, такие как лояльность, счастье, боль или ценности. Следствием этого является то, что в зависимости от дизайна или информации, на которой он обучен, агент ИИ может действовать против человеческих интересов.

Рассмотрим следующий пример из области ухода за престарелыми: робот-агент ИИ тренируется для максимального повышения благосостояния пожилой женщины с ухудшением здоровья из-за болезни Паркинсона. Агент предоставляет ей постоянный уход и внимание во избежание рискованных ситуаций, которые могут нанести ей вред. Но чтобы снизить риск падения, агент ИИ начинает контролировать ее возможности выйти из своей квартиры. Хотя этот подход эффективно снижает риск получения травмы и не ухудшает ее физическое состояние, он снижает ее социальный контакт, приводя к спирали депрессии. Этот пример показывает, что ИИ может не иметь «плохих намерений» априори, но его действия могут иметь негативное влияние, если его диапазон целей плохо разработан. Такие проблемы все более актуальны для приложений, в которых пользователи чувствительны, например дети и пожилые люди.

Задача при разработке агентов ИИ - привить агенту различие между хорошим и плохим. Один из способов – это позволить агенту наблюдать поведение человека в разных ситуациях и действовать соответствующим образом. Чем дольше агент ИИ наблюдает за людьми, тем более добродетельным, по человеческим меркам, становится агент ИИ. Однако у людей есть предрассудки и предубеждения.

* Восклицательные знаки для каждого типа воздействия указывают на две наиболее важные области, вызывающие озабоченность.

Источник: Allianz Consulting и Allianz Global Corporate & Specialty

Меню

Allinsurance.kz

Казахстанский портал о страховании

Allinsurance.kz

Казахстанский портал о страховании

18

Чт, сен